La carta, firmada por el 5% del personal, sostiene que contratos con gobiernos y militares violan el compromiso de Google.

Casi 200 empleados de Google DeepMind, la división de inteligencia artificial de la empresa, han firmado una carta solicitando que Google termine sus contratos con organizaciones militares, según un artículo publicado hoy en la página digital de TIME. La misiva, fechada el 16 de mayo de este año, refleja una creciente preocupación entre los trabajadores sobre el uso de la tecnología de DeepMind en conflictos bélicos, considerándolo una violación de las normas éticas de inteligencia artificial de Google.

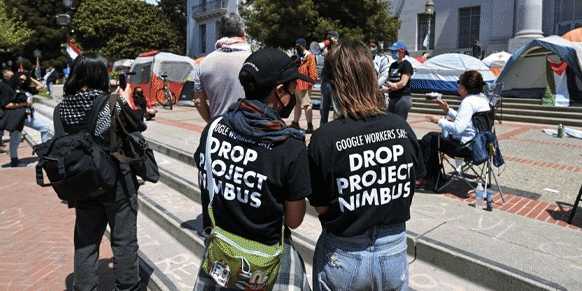

La carta, que representa aproximadamente el 5% del personal de DeepMind, argumenta que los contratos de Google con gobiernos y militares contradicen el compromiso de la empresa con el desarrollo ético y responsable de la IA. Aunque el documento no menciona conflictos específicos, hace referencia a un informe de TIME que detalla el contrato de Google con el ejército israelí bajo el Proyecto Nimbus, el cual incluye servicios en la nube y tecnologías de IA.

Google ha afirmado que el contrato con Israel no está dirigido a trabajos militares sensibles. Sin embargo, los empleados de DeepMind están preocupados de que la tecnología de la empresa pueda estar involucrada en actividades que contravengan los principios de la empresa, como la fabricación de armas o la vigilancia masiva.

Los trabajadores piden a los líderes de DeepMind que investiguen el uso militar de la tecnología, terminen el acceso para usuarios militares y establezcan un nuevo organismo de gobernanza para prevenir futuros usos militares de la tecnología de DeepMind. Hasta ahora, Google no ha respondido de manera significativa a estas demandas, lo que ha generado frustración entre los empleados.

Desde que DeepMind fue adquirido por Google en 2014, se había asegurado que la tecnología no se utilizaría para fines militares. Sin embargo, con la fusión de DeepMind con el equipo de IA de Google en 2023 y la integración de la tecnología en el software en la nube de Google, la situación ha cambiado. La política de ética de Google permite desarrollar tecnologías que podrían causar daño si los beneficios superan los riesgos, lo que no excluye la posibilidad de vender IA a clientes militares.